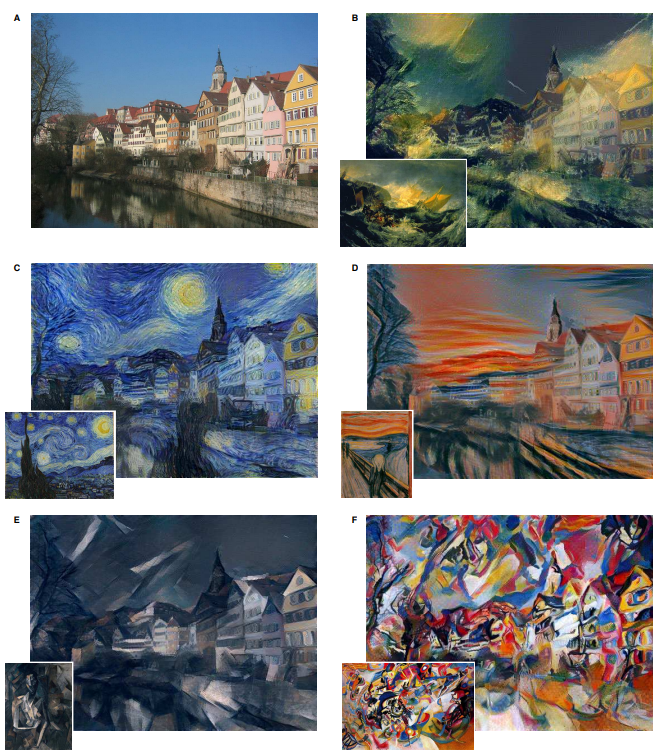

앞으로 3주동안에는 이안 굿펠로우의 GAN 튜토리얼을 요약하면서 스터디가 진행이 됩니다. 아래 내용은 이번 스터디에서 발표된 내용입니다. 1. 컴퓨터 비전 인식: 이미지 내에 존재하는 정보를 찾는 기술입니다. 생성: 특정 정보를 담는 이미지를 생성하는 기술입니다. 학습하는 방식에는 Supervised Learning과 Un-supervised Learning이 있습니다. 나눠지는 기준은 레이블의 유무, 그리고 어떠한 목적으로 학습이 진행되는지에 따라서 나눠지게 됩니다. Supervised Learning은 매핑할 함수를 학습하는 목적을 가지고 있고 Un-Supervised Learning은 주어진 데이터 속 숨겨진 패턴을 학습하는 목적을 가집니다. 생성모델 생성 모델은 학습 데이터 하나하나를 학습하는 것..