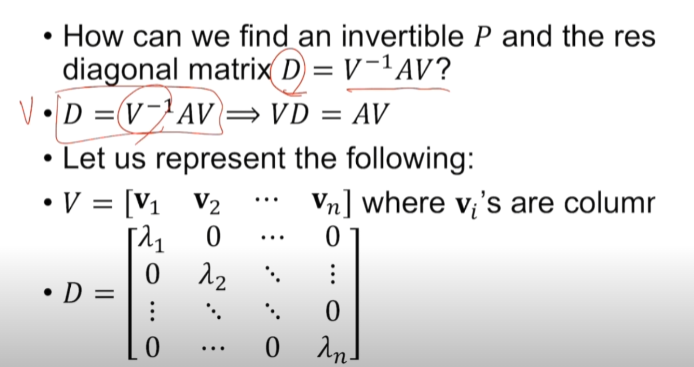

대각화란 주어진 행렬을 대각행렬로 만드는 것을 말합니다. 기본적으로 square matrix를 사용합니다. $D = V^{-1}AV$ A라는 matrix에 V와 V의 역행렬을 곱해주어 대각 성분만 남게 만듭니다. 이 방법은 항상 가능한 것이 아니라 상황에 따라 달라집니다. 위에 식을 만족시키는 V를 찾을 수 있는 경우에만 대각화가 가능합니다. V의 shape은 A의 shape과 동일합니다. $VD = AV$란 식을 얻었습니다. A가 (3, 3) 행렬이라고 할 때 V도 (3, 3) 행렬이 됩니다. $AV_1 = \lambda V_1...$ 여기서 $V$를 Eigenvector $\lambda$를 Eigenvalue로 생각해보면 이전에 배웠던 Eigenvalue, Eigenvector가 만족해야 하는 식과 ..